Nachdem mein Macbook Pro auch schon wieder mehr als 4 Jahre auf dem Buckel hatte, musste ich langsam akzeptieren, dass das nächste kein Macbook mehr sein konnte. Ungelöste Mechanikprobleme an den aktuellen Tastaturen, fehlende Esc-Taste, und das ganze, da es ein dedizierter Grafikchipsatz sein sollte, ausschließlich zu abenteuerlichen Preisen um 3000 Euro. Da musste Apple leider mal draußen bleiben.

Nach qualvoller Evaluierung der Optionen entschied ich mich für das neue Dell Alienware m15 mit US-Tastatur, mattem 15.6″ Full-HD-Bildschirm mit 144Hz, Intel Core i7-8750H (6 Core, 12 Threads), 16 GB Arbeitsspeicher, Nvidia Geforce GTX 1060 und 3 Jahren Next-Day vor-Ort-Service. Die gewählte Konfiguration hat keine 2,5″-SATA-Festplatte mehr, sondern einen entsprechend von 60Wh auf 90Wh vergrößerten Akku.

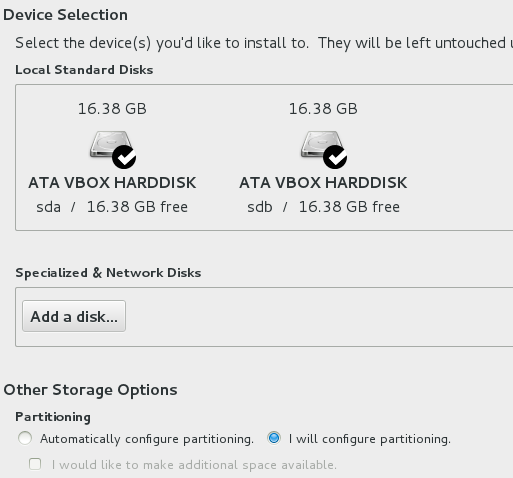

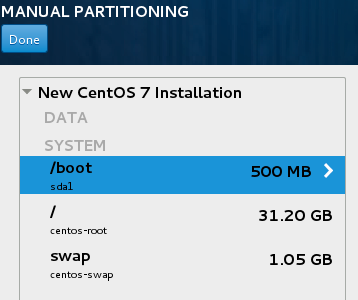

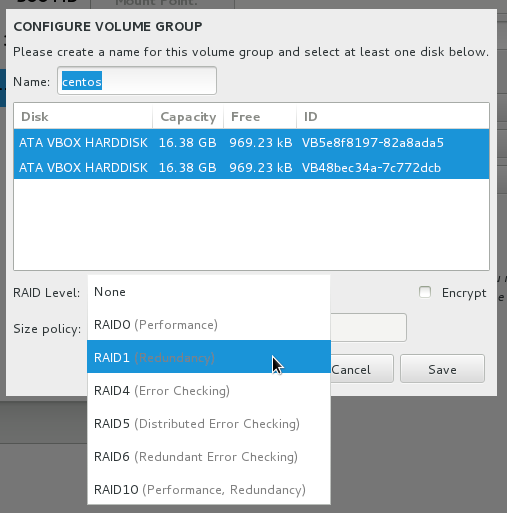

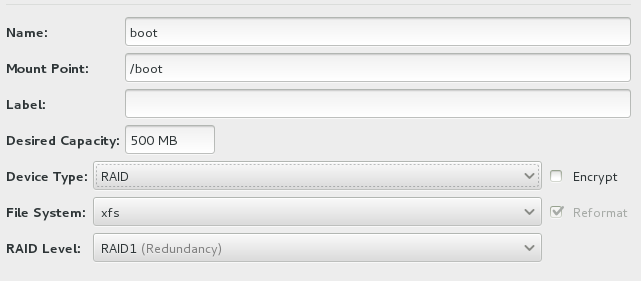

Als Massenspeicher hatte ich das NVMe-Modul mit 256GB gewählt, das ich sofort nach Lieferung durch eines von Samsung mit 1TB getauscht habe. Bemerkenswert ist, dass noch ein zweiter NVMe-Slot frei ist, so dass man sich auch eine schicke und schnelle RAID-Konfiguration bauen könnte.

Das Gehäuse des m15 ist das flachste, das Alienware bisher angeboten hat. In Relation zum Display hat es aber einen auffallend großen Fußabdruck und hat ein 4:3-Format. Die sehr breiten schwarzen Ränder ober- und speziell unterhalb des Display habe ich zu Anfang als sehr störend empfunden. Ich nehme den ca. 5cm breiten unteren Rand aber aktuell als ergonomisch äußerst vorteilhaft wahr, da er das Display auf eine bessere Betrachtungsposition anhebt.

Tastatur und Verarbeitung gefallen mir sehr gut. Das Gehäuse sieht zwar sogar dort, wo es hochwertig aussehen soll, äußerst plastikhaft aus, ist aber tatsächlich aus Metall und gibt nirgends nach. Störend ist lediglich die geriffelte Fläche oberhalb der Tastatur, die Staub magisch anzieht. Um- und Aufrüstungen am m15 sind sehr einfach möglich, indem eine Handvoll Phillips-Schrauben rausgedreht werden und die untere Gehäusehälfte rundum mit einer einschlägigen Plastikkarte ausgeclipst wird. Danach liegen die NVMe- und RAM-Slots direkt frei. Hat man sich einmal an die sehr gute Tastatur des m15 gewöhnt und bekommt wieder eine Macbook-Tastatur unter die Finger, ist die Macbook-Tastatur mit ihrem widerwilligen Druckpunkt merklich schlechter.

Mit dem vorinstallierten Windows 10 hatte ich unglaublich viele Probleme vor allem im Bereich irgendwelcher Systemdateien, deren Ownership nicht stimmte. Das Diagnose-Tool von Samsung konnte nicht auf die SSD zugreifen, weil die NVMe-Slots im BIOS als “RAID” konfiguriert waren, was ich durchaus als unangenehme Schräglage empfand. Nach einer kompletten Windows-Neuinstallation macht das System keinerlei Probleme mehr und wirkt nicht mehr, als stamme es von einem besonders lieblos geklonten Image ab.

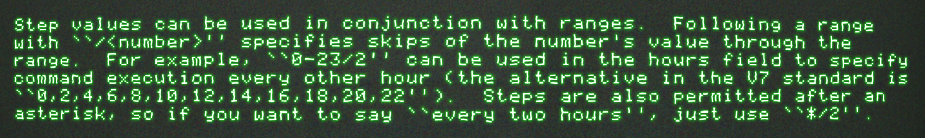

Erwartungsgemäß können die Lüfter des Notebook auch bei mäßigem Gebrauch immer mal wieder hörbar werden, etwa bei abenteuerlichen Workloads wie dem Betrachten eines Twitter-Feed mit einem eingebetteten animierten GIF. Die mitgelieferten Tools von Alienware sind erwartungsgemäß zu wenig zu gebrauchen, unter anderem auch nicht zum Heruntertakten des Prozessors. Mit dem einschlägig bekannten Tool ThrottleStop lässt sich der Takt aber soweit einschränken, dass das Gerät praktisch lautlos bleibt und man es bedenkenlos auf Knien oder Sofakissen benutzen kann. Wo man gerade dabei ist, erledigt man am besten auch die Belegung der Macro-Tasten über ein externes Tool. Mit Sharp Keys kann man sie etwa zu den Funktionstasten F13-F16 erklären, das ganze in die Registry schreiben (so dass Sharp Keys auch gleich wieder weg kann, vorzugsweise nachdem man auch CapsLock deaktiviert hat) und die neuen F-Tasten nach Geschmack mit Funktionen belegen. Ich schalte mit Macro 1 und Macro 2 zwischen dem mit ThrottleStop konfigurierten “Silent-/Batterie-Modus” und voller Leistung um.

Das Zusammenspiel zwischen CPU-Grafik und Nvidia-Grafik entpuppt sich dank irgendwelcher automatischer “Optimierungen”, die Alienware und der Nvidia-Treiber glauben vornehmen zu müssen, als größeres Gewurste, als erwartet. Läuft mein Spiel nun mit 60 FPS, weil irgendein Optimierungsquatsch das für ausreichend hält (wohlgemerkt auf einem 144Hz-Display, für das ich Aufpreis bezahlt habe), oder läuft es vielleicht auf der CPU statt auf dem Nvidia-Chipsatz? Diese Optimierungen sollen der Geräusch- und Wärmebegrenzung sowie der Verlängerung der Batterielaufzeit dienen, aber ernsthaft, wenn ich auf meinem 144Hz-Laptop ein Spiel starte, dann sitze ich mit Netzteil an der Steckdose, und sonst nirgends. Leider habe ich es aufgrund dieser Probleme noch nicht geschafft, Doom 2016 in einer Qualität laufen zu lassen, die an die Nvidia Geforce GTX 960 im einige Jahre alten stationären PC heranreicht. Counterstrike: Global Offensive geht dafür sehr gut. Immerhin.

Mit gedrosseltem Prozessor, auf 60Hz gedrosseltem Bildschirm (diese Drosselung muss man natürlich auch wieder mit einem externen Tool freischalten) und einfachen Workloads liegt die Batterielaufzeit oberhalb von 5 Stunden, womit sich auch längere Meetings problemlos bestreiten lassen.

Vom integrierten Ethernet-Port hatte ich mir einiges versprochen, aber die Warnungen, die mich diesbezüglich erreicht hatten, waren leider zutreffend und die Einbauposition sorgt bei besser verarbeiteten RJ45-Steckern wie dem Hirose TM31 dafür, dass diese sich von selbst entriegeln und das Kabel aus dem Port flutscht. Zuhause benutze ich also hauptsächlich einen USB-Ethernet-Adapter, den ich im Zweifelsfall zwecks Zugentlastung auf der jeweils anderen Gehäuseseite einstecken kann.

Der Umstieg vom Macbook zum Windows-Notebook war nicht wirklich schmerzhaft. Das einzige störende Element ist, dass man Windows immer in den Tiefschlaf schicken muss, da man bei Nutzung des normalen Ruhemodus wie unter MacOS praktisch täglich einen brüllend heißen Rechner aus der Tasche holt, der im zugeklappten Zustand aufgewacht ist.

Meine UNIX-Shell unter Windows habe ich per Cygwin abgebildet, und ansonsten sind die wichtigsten Tools (LibreOffice, Firefox, Thunderbird, GIMP) identisch mit denen, die ich auch unter MacOS oder Linux benutzen würde. Die “großen” kommerziellen Softwarepakete (in meinem Fall Adobe CC und DxO PhotoLab) sind heutzutage alle doppelt für MacOS und Windows lizensiert, so dass es hier zu keinen Überraschungen kam.

Da der Rechner nicht primär als Spiele-PC benutzt wird, hätte ich auf 144Hz zugunsten der besseren Farbtreue des 60Hz-Display verzichten oder sogar die Variante mit der höheren Auflösung wählen können. Davon abgesehen, bin ich mit dem Gerät sehr zufrieden und kann unter der Voraussetzung, dass nicht versucht wird, das vorinstallierte Windows zu benutzen, für das Alienware m15 eine klare Empfehlung aussprechen.